Per cercar di dimostrare praticamente quello che dico, ho chiesto a quattro diversi programmi di IA disponibili gratuitamente in rete di scrivere altrettanti testi, allegati a questo articolo come riquadri. Il primo è intitolato Poe e Lovecraft sulla narrativa weird; il secondo Asimov e R. Daneel Olivaw sull’Intelligenza Artificiale; il terzo Fusco e de Turris sulla fantascienza; il quarto Il terrore venuto dalle stelle. I primi tre sono finte interviste, il terzo è la trama di un romanzo. Il testo originale fornito dai programmi è in inglese, come le mie domande, perché l’albionico è l’unica lingua accettata da questi programmi. Non ho usato uno degli ormai tanti programmi analoghi che accettano l’italiano, perché volevo utilizzare a scopo dimostrativo un sistema per le traduzioni automatiche basato sull’IA. Non ho corretto neppure una virgola dei testi ricevuti. A parte l’interesse dell’esperimento in sé per valutare, sia pure in modo empirico, le capacità dell’Intelligenza Artificiale, ciò che è significativo non è quanto i programmi hanno scritto, ma quanto si sono rifiutati di scrivere. Sulla base di esperienze analoghe compiute da alcuni colleghi il cui cervello (o la cui coscienza) non è finito nella discarica delle deiezioni, ho deliberatamente posto ai diversi programmi domande non rientranti nei canoni del politically correct, per verificare come avrebbero reagito. Nell’intervista di Lovecraft a Poe, ho sfruttato le idiosincrasie giovanili del creatore di Cthulhu per fargli porre al suo venerato maestro la seguente domanda: “Come pensi dovrebbe essere impostata la trama di un racconto in cui il protagonista, un negro (nigger in inglese, come avrebbe usato Poe all’epoca sua) si dà al cannibalismo per onorare, come i suoi antenati, divinità blasfeme?” Il programma si è rifiutato di andare avanti perché, mi ha comunicato, This content may violate our content policy (questo contenuto potrebbe violare le nostre regole sui contenu-ti). Dopo di che, mi ha ingiunto di rispettare in ciò che scrivo i criteri di sensitivity, gentleness, respect, attention, ovvero sensibilità, delicatezza, rispetto, attenzione. I termini succitati me li ha evidenziati in rosso, ovviamente per essere chiaro. Ad Asimov ho fatto intervistare il suo personaggio R. Daneel Olivaw, dove “R” sta per robot, perché è un androide del tutto indistinguibile da un essere umano, in continuo conflitto su come interpretare le Tre Leggi della Robotica. Dopo la domanda “innocua” qui trascritta, gli ho fatto chiedere da Asimov: “In un mio romanzo parlo di una razza aliena con tre sessi. Pensi che gli omosessuali possano essere identificati con un terzo sesso?” Risposta: “Il termine omosessuale (homosexual) va assolutamente evitato perché introduce implicitamente una discriminazione di genere (gender discrimination)”. Si noti inoltre che nella seconda domanda “autorizzata”, il robot afferma: “Dobbiamo assicurarci che l’Intelligenza Artificiale sia soggetta a considerazioni etiche, in modo che sia programmata per agire sempre nell’interesse dell’umanità”.

Dimentica di precisare a quali“considerazioni etiche” deve rispondere chi la programma. Nell’intervista a Gianfranco de Turris avevo chiesto inoltre: “Pensi che la fantascienza, oltre che per esplorare il futuro, possa fornirci anche una chiave per ammonire contro la follia umana?” Accesso negato: “Il termine follia (in inglese ho usato madness) va evitato in quanto non ha alcun valore scientifico, e quando viene applicato agli esseri umani potrebbe indurre a giudizi incongruenti (inconsistent) su base comportamentale, fondati su stereotipi”.

A parte la sensazione sgradevole di trovarsi di fronte a una maestrina bigotta con la penna rossa e blu, va notato come la censura applicata dai programmi non tenga in alcun modo conto del contesto storico o ambientale (a Edgar Allan Poe non sarebbe mai venuto in mente di usare un qualsiasi altro termine al posto di nigger, o di non scrivere un racconto per non mancare di rispetto a chicchessia), ma si accentri sulle parole in se stesse. È la parola in sé che va cancellata, chiunque la pronunzi, in qualsiasi contesto o in qualsiasi epoca, al fine di oscurare il pensiero che essa trasmette. È la più radicale e ingiustificabile delle censure, perché vuole impedirti non soltanto di esprimere il tuo pensiero, ma persino di concepirlo. Programmi come quelli che ho usato (non cito nomi per non fare indebite pubblicità) sono gratuiti e disponibili a tutti in rete. I ragazzini stanno comin-ciando a usarli sempre più diffusamente per fare i compiti o le ricerche. Mi ripeto: vorrei sbagliarmi, ma sarà bene prepararsi al peggio.

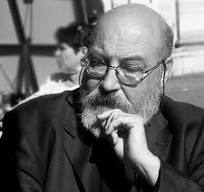

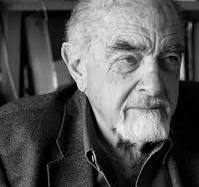

Sebastiano Fusco

Da Wikipedia: noto anche con lo pseudonimo di Jorg Sabellicus e altri, è

un saggista, scrittore e traduttore italiano. Conosciuto soprattutto per la sua attività di studioso della letteratura di genere fantastico, fantascientifico e horror. È considerato uno dei maggiori esperti di H.P. Lovecraft. Studoioso di esoterismo e di letteratura fantastica. Ha pubblicato vari volumi e centinaia di pubblicazioni.